Tesla aún no ha cumplido con la NHTSA, recibe una semana más de tiempo

Era cuestión de tiempo, y pasó. Joshua Brown, un conductor que confiaba ciegamente en la eficacia del Autopilot de Tesla, murió cuando su coche se empotró contra un camión. Tiempo después, la autoridad competente en seguridad de EEUU, la NHTSA, pidió explicaciones a Tesla

El hasta el momento único accidente mortal de un Tesla con el sistema de conducción semiautónoma activado, el Autopilot, está siendo toda una fuente de quebraderos de cabeza para la empresa de Elon Musk. A pesar de ser un sistema que exige que el conductor esté pendiente, algunos no lo hacen, y pasan completamente de las advertencias dentro y fuera del coche.

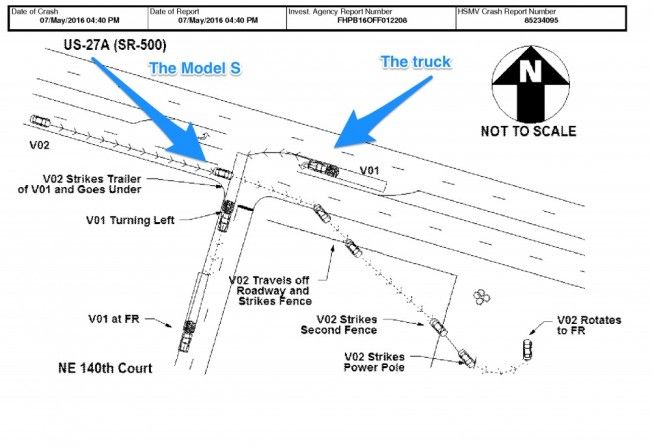

La NHTSA quiere saber qué pasó exactamente en ese accidente. Según la investigación preliminar, el camión contra el que se empotró el coche atravesaba la calzada transversalmente, y el Tesla no aminoró la marcha porque no lo captó con sus sensores. Hay que recordar que no está diseñado para eso, es un sistema para vías sin intersecciones al mismo nivel.

El accidente ocurrió en mayo, la NHTSA hizo una petición de información en julio, y Tesla tenía de plazo hasta esta semana para desvelar la información. Al haberse violado el plazo, la NHTSA ha dado una semana más para que Tesla aporte toda la información que tenga sobre el funcionamiento de Autopilot y sus limitaciones, si se ha hecho alguna mejora, etc.

Croquis del accidente mortal de Joshua Brown

Recordemos cómo funciona. Autopilot no solo mantiene la velocidad de crucero -considerando lo que permite el tráfico- sino que mantiene la dirección dentro del carril y es capaz de cambiar de uno a otro. Algunos clientes lo confunden con que el coche conduce solo, y se desentienden de la conducción en mayor o menor grado.

En un coche equipado con asistencias a la conducción de similar propósito, el conductor está obligado a dar señales de vida cada cierto tiempo, de lo contrario el sistema se desactiva. El sistema de Tesla es más permisivo, se puede estar sin tocar el volante ni los pedales durante varios kilómetros, lo que ha propiciado abusos y conductas totalmente irresponsables por parte de los clientes.

La propia víctima, Joshua Brow, era famosa por sus vídeos alabando la eficacia del sistema, aunque se excediese en la exhibición de sus posibilidades. El sistema aprende constantemente y los coches contribuyen a una especie de inteligencia colectiva, que lo va mejorando. Aunque se ha probado -matemáticamente- como más seguro que conducir manualmente, dista de ser perfecto y tiene sus limitaciones.

De momento el fabricante está reaccionando y va a limitar las prestaciones de Autopilot en la actualización 8.0 del software del coche, pero también va a mejorarlo. Los conductores renegados que ignoren las advertencias serán "castigados" en último término con la desactivación del sistema, la obligación de parar completamente, y luego reactivarlo. Tesla quiere evitar más mala prensa, aunque sea por culpa de sus clientes y de nadie más.

En el caso de Joshua Brow, el radar frontal no detectó el camión por irrumpir transversalmente, o por haberlo confundido con un edificio. El sistema también utiliza información de la cámara frontal, pero debido al color del remolque, las condiciones lumínicas y el cielo despejado, literalmente no pudo verlo. Eso es lo que sabemos hasta ahora.

De haber percibido el coche el peligro, habría aminorado la marcha, o lo habría intentado esquivar. Lo mismo podemos presuponer del conductor, pero al parecer iba viendo una película y no prestaba atención a lo que ocurría. Cuando el techo del coche impactó contra la parte inferior del remolque, seguramente Brown murió en el acto sin haberse enterado de nada. La parte inferior del coche pasó por debajo del remolque y continuó unos cuantos metros más.

La llegada de la conducción autónoma plantea una serie de dilemas morales, legales, éticos, etc. Hasta que no hablemos de vehículos 100% autónomos, sin mandos, la responsabilidad va a ser del conductor. Tenemos la excepción de Volvo, que asumirá la responsabilidad de lo que hagan sus coches cuando no circulen en modo manual. La legislación al respecto todavía no se ha desarrollado.

Conducir implica tomar decisiones con la información disponible. El Tesla Model S de Brown no interpretó ningún peligro y por eso no realizó ninguna acción. Se suponía que el conductor habría visto el peligro, habría pisado el pedal del freno, y nada habría ocurrido. Pero todo esto es información preliminar, tenemos que esperar al informe que publique la NHTSA para saber qué ha pasado.

A buen seguro los ingenieros de Tesla están trabajando para que eso no vuelva a ocurrir, aunque los coches se vuelvan más "prudentes" y aumenten su sensibilidad al peligro. Esto podría desembocar en más de un frenazo o deceleración inesperada si se interpreta que hay un peligro, porque todo depende de qué captan los sensores, es información que se interpreta, y con ella se toman las decisiones.

Fuente: Business Insider